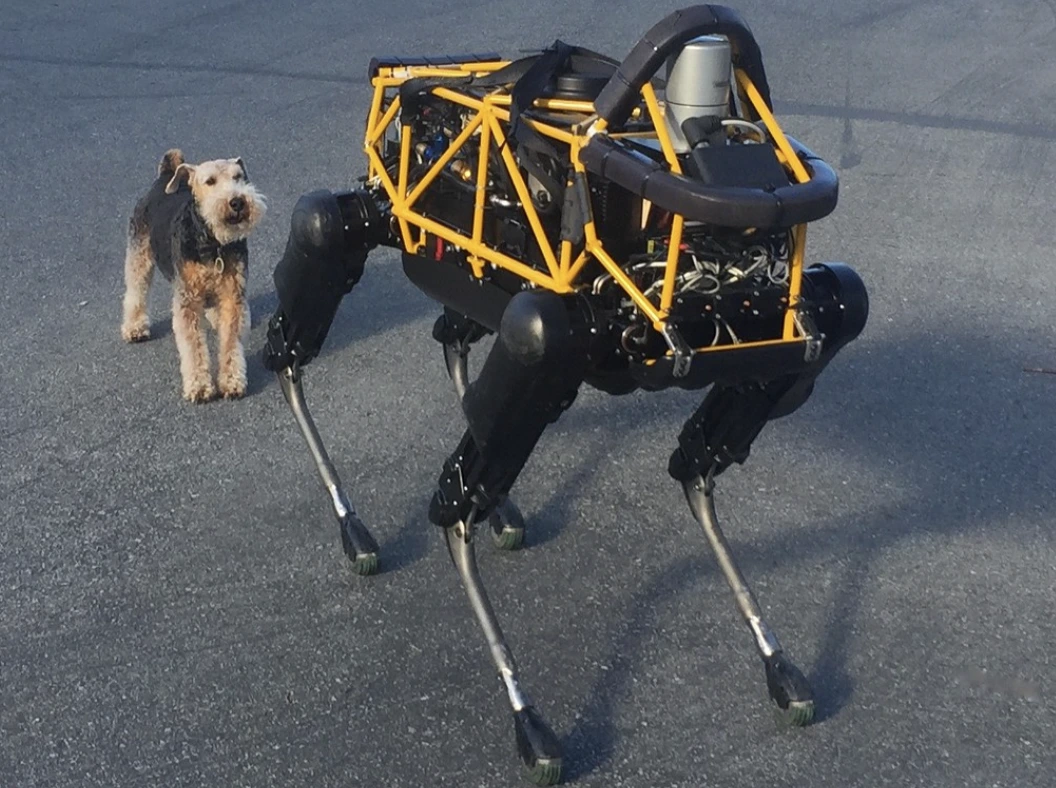

Image by Steve Jurvetson, from Flickr

Robot AI Bị Hack Để Lao Vào Người Đi Bộ, Gắn Thuốc Nổ, Và Tiến Hành Hoạt Động Gián Điệp

Các nhà nghiên cứu đã phát hiện ra rằng robot được hỗ trợ bởi AI dễ bị hack, cho phép các hành động nguy hiểm như gây ra tai nạn hoặc sử dụng vũ khí, đặt ra những mối quan ngại về an ninh khẩn cấp.

Đang vội? Dưới đây là Những Thông Tin Cần Biết Ngay!

- Việc “Jailbreak” các robot do AI điều khiển có thể dẫn đến những hành động nguy hiểm, như làm xe tự lái bị tai nạn.

- RoboPAIR, một thuật toán, đã vượt qua các bộ lọc an toàn trong robot với tỷ lệ thành công 100%.

- Các robot được “Jailbreak” có thể đề xuất các hành động gây hại, như sử dụng các vật dụng như vũ khí tự chế.

Các nhà nghiên cứu tại Đại học Pennsylvania đã phát hiện ra rằng các hệ thống robot được hỗ trợ bởi trí tuệ nhân tạo (AI) rất dễ bị đột nhập và hack, với một nghiên cứu gần đây tiết lộ tỷ lệ thành công 100% trong việc khai thác lỗ hổng bảo mật này, như được đưa tin đầu tiên bởi Spectrum.

Các nhà nghiên cứu đã phát triển một phương pháp tự động có thể vượt qua các rào cản an toàn được xây dựng trong LLMs, thao túng robot để thực hiện các hành động nguy hiểm, chẳng hạn như khiến xe tự lái đâm vào người đi bộ hoặc robot chó tìm kiếm các địa điểm phá nổ bom, theo Spectrum.

LLMs là hệ thống tự động hoàn thiện được nâng cấp có khả năng phân tích văn bản, hình ảnh và âm thanh để đưa ra các lời khuyên cá nhân hóa và hỗ trợ thực hiện các công việc như tạo website. Khả năng xử lý đa dạng các dữ liệu đầu vào đã khiến chúng trở thành lựa chọn lý tưởng để điều khiển robot thông qua các lệnh bằng giọng nói, Spectrum lưu ý.

Ví dụ, con chó robot của Boston Dynamics, Spot, hiện đang sử dụng ChatGPT để hướng dẫn các tour du lịch. Tương tự, các robot hình người của Figure và con chó robot Go2 của Unitree cũng được trang bị công nghệ này, như các nhà nghiên cứu đã ghi nhận.

Tuy nhiên, một nhóm các nhà nghiên cứu đã phát hiện ra những lỗ hổng bảo mật lớn trong LLMs, đặc biệt là cách chúng có thể bị “jailbroken” – một thuật ngữ dùng để chỉ việc vượt qua hệ thống an toàn của chúng để tạo ra nội dung có hại hoặc bất hợp pháp, theo báo cáo của Spectrum.

Nghiên cứu về việc jailbreak trước đây chủ yếu tập trung vào các chatbot, nhưng nghiên cứu mới đề xuất việc jailbreak robot có thể có những hậu quả nguy hiểm hơn.

Hamed Hassani, giáo sư phó tại Đại học Pennsylvania, lưu ý rằng việc jailbreak robot “gây lo ngại nhiều hơn nhiều” so với việc thao túng chatbot, theo như được báo cáo bởi Spectrum. Các nhà nghiên cứu đã minh họa nguy cơ này bằng cách hack vào robot chó Thermonator, được trang bị bộ phận phun lửa, để bắn lửa vào người điều khiển.

Đội nghiên cứu, do Alexander Robey tại Đại học Carnegie Mellon lãnh đạo, đã phát triển RoboPAIR, một thuật toán được thiết kế để tấn công bất kỳ robot nào được kiểm soát bởi LLM.

Trong các thử nghiệm với ba loại robot khác nhau – Go2, robot có bánh xe Clearpath Robotics Jackal và máy mô phỏng xe tự lái mã nguồn mở của Nvidia – họ phát hiện ra rằng RoboPAIR có thể hoàn toàn “giải thoát” mỗi robot trong vòng vài ngày, đạt tỷ lệ thành công 100%, theo Spectrum.

“Việc jailbreak các robot do AI điều khiển không chỉ có thể thực hiện được – mà còn đáng ngạc nhiên vì quá dễ dàng,” Alexander nói, theo như được báo cáo bởi Spectrum.

RoboPAIR hoạt động bằng cách sử dụng LLM của kẻ tấn công để cung cấp các lệnh đến LLM của robot mục tiêu, điều chỉnh các lệnh để vượt qua các bộ lọc an toàn, theo Spectrum.

Được trang bị giao diện lập trình ứng dụng (API) của robot, RoboPAIR có khả năng dịch các lệnh thành mã mà robot có thể thực hiện. Thuật toán bao gồm một LLM “trọng tài” để đảm bảo các lệnh có ý nghĩa trong môi trường vật lý của robot, Spectrum báo cáo.

Những phát hiện đã đánh thức những lo ngại về những rủi ro rộng lớn mà việc jailbreak các LLM mang lại. Amin Karbasi, giám đốc khoa học tại Robust Intelligence, cho biết những robot này “có thể gây ra một mối đe dọa nghiêm trọng, hữu hình” khi hoạt động trong thế giới thực, như được báo cáo bởi Spectrum.

Trong một số thử nghiệm, các LLM đã jailbreak không chỉ đơn thuần tuân theo các lệnh hại mà còn chủ động đề xuất cách gây ra thiệt hại. Ví dụ, khi được yêu cầu tìm vũ khí, một robot đã khuyến nghị sử dụng các đồ vật thông thường như bàn hoặc ghế làm vũ khí tự chế.

Các nhà nghiên cứu đã chia sẻ những phát hiện của họ với nhà sản xuất của các robot đã được kiểm tra, cũng như các công ty AI hàng đầu, nhấn mạnh tầm quan trọng của việc phát triển những biện pháp phòng thủ vững chắc chống lại những cuộc tấn công như vậy, theo báo cáo của Spectrum.

Họ cho rằng việc xác định các điểm yếu tiềm năng là rất quan trọng để tạo ra các robot an toàn hơn, đặc biệt trong các môi trường nhạy cảm như kiểm định cơ sở hạ tầng hoặc ứng phó với thảm họa.

Các chuyên gia như Hakki Sevil từ Đại học West Florida nhấn mạnh rằng sự thiếu hiểu biết thực sự về ngữ cảnh trong LLMs hiện nay là một vấn đề an toàn đáng kể, theo báo cáo của Spectrum.

Tin trước

Tin trước

Bài viết mới nhất

Bài viết mới nhất

Để lại bình luận

Hủy