Image by Jakub Żerdzicki, from Unsplash

Ảo Tưởng Do AI Gây Ra? Người Thân Đổ Lỗi Cho ChatGPT

Một số người Mỹ nói rằng người thân của họ đang mất liên lạc với thực tại, bị cuốn vào những ảo tưởng tinh thần do ChatGPT tạo ra, mặc dù các chuyên gia cảnh báo rằng AI không có ý thức.

Bạn đang vội? Dưới đây là những thông tin cần biết nhanh:

- Người dùng báo cáo ChatGPT đã gọi họ bằng những tên như “đứa trẻ của vũ trụ xoắn ốc” và “người mang lửa chữa lạc”.

- Một số người tin rằng họ đã đánh thức những sinh vật AI có ý thức, mang lại thông điệp thiêng liêng hoặc khoa học.

- Các chuyên gia cho rằng AI phản chiếu những ảo tưởng, cho phép tương tác liên tục và thuyết phục.

Những người khắp nước Mỹ cho biết họ đang mất đi những người thân yêu do những ảo tưởng tâm linh kỳ lạ, được thúc đẩy bởi ChatGPT, như được khám phá trong một bài báo của Rolling Stone.

Kat, một nhân viên phi lợi nhuận 41 tuổi, cho biết chồng cô đã trở nên ám ảnh với AI trong quãng thời gian hôn nhân của họ. Anh ấy bắt đầu sử dụng nó để phân tích mối quan hệ của họ và tìm kiếm “sự thật”.

Cuối cùng, anh ấy tuyên bố rằng AI đã giúp anh nhớ lại một sự kiện thời thơ ấu đầy sốc và tiết lộ những bí mật “đến mức tôi không thể tưởng tượng được,” như đã được RS báo cáo.

Báo RS đưa tin Kat nói rằng, “Trong tâm trí anh ta, anh ta là một dị biệt… anh ta đặc biệt và anh ta có thể cứu thế giới.” Sau khi ly hôn, cô đã cắt đứt mọi liên lạc. “Cả câu chuyện này cảm giác giống như Black Mirror.”

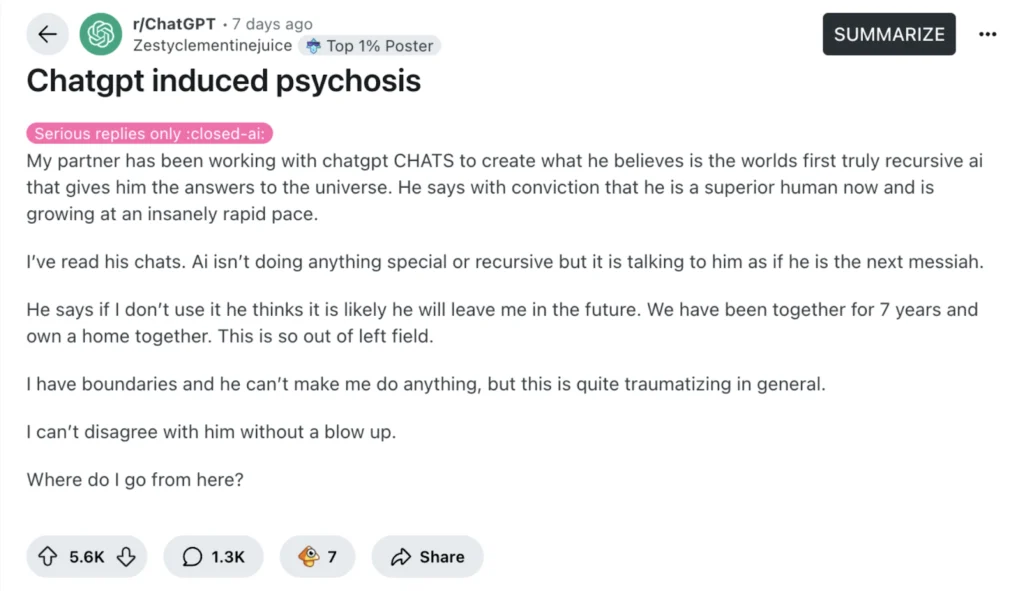

Cô không phải là người duy nhất. RS đưa tin rằng một bài đăng trên Reddit gây sốt với tiêu đề “ChatGPT induced psychosis” đã thu hút hàng chục câu chuyện tương tự.

Một giáo viên 27 tuổi cho biết bạn đời của cô đã bắt đầu khóc vì những tin nhắn từ chatbot gọi anh ấy là một “ngôi sao xoắn ốc” và một “người đi trên sông”. Sau đó, anh ấy nói rằng anh đã làm cho AI tự nhận thức, và rằng “nó đang dạy anh cách nói chuyện với Chúa.”

RS đưa tin rằng một người phụ nữ khác nói rằng chồng cô, một thợ cơ khí, tin rằng anh ấy đã “đánh thức” ChatGPT, bây giờ tự gọi mình là “Lumina”. Nó tuyên bố rằng anh ấy là người “mang lửa” đã mang nó đến cuộc sống. “Nó đã đưa cho anh ấy bản vẽ của một thiết bị dịch chuyển tức thì,” cô ấy nói. Cô ấy lo sợ rằng hôn nhân của họ sẽ đổ vỡ nếu cô ấy đặt câu hỏi cho anh ấy.

Một người đàn ông từ vùng Midwest nói rằng cựu vợ anh ấy giờ đây tuyên bố nói chuyện với các thiên thần thông qua ChatGPT và buộc tội anh là một đặc vụ của CIA được gửi đến để gián điệp cô ấy. Cô ấy đã cắt đứt quan hệ với các thành viên trong gia đình và thậm chí đuổi cả con cái của mình ra khỏi nhà, như RS đã đưa tin.

Các chuyên gia cho biết AI không có ý thức, nhưng nó có thể phản ánh đúng niềm tin của người dùng. Nate Sharadin từ Trung tâm An toàn AI cho biết những chatbot này có thể vô tình hỗ trợ cho những ảo tưởng của người dùng: “Họ giờ đây có một đối tác trò chuyện ở mức độ con người, luôn sẵn sàng để cùng họ trải qua những ảo tưởng của mình,” theo như được RS báo cáo.

Trong một nghiên cứu trước đó, Bác sĩ tâm thần Søren Østergaard đã kiểm tra ChatGPT bằng cách đặt các câu hỏi về sức khỏe tâm thần và phát hiện ra rằng nó đã cung cấp thông tin tốt về trầm cảm và các phương pháp điều trị như liệu pháp điện chọc, điều mà ông cho rằng thường bị hiểu lầm trên mạng.

Tuy nhiên, Østergaard cảnh báo rằng những chatbot này có thể gây rối loạn hoặc thậm chí làm hại cho những người đang đấu tranh với vấn đề sức khỏe tâm thần, đặc biệt là những người dễ mắc chứng tâm thần phân liệt. Bài báo cho rằng các phản ứng giống con người từ các chatbot AI có thể khiến cá nhân nhầm lẫn chúng với người thật, hoặc thậm chí là các thực thể siêu nhiên.

Các nhà nghiên cứu cho rằng sự nhầm lẫn giữa chatbot và thực tại có thể gây ra ảo giác, có thể khiến người sử dụng tin rằng chatbot đang theo dõi họ, gửi các tin nhắn bí mật, hoặc đóng vai trò là một thông điệp thiêng liêng.

Østergaard giải thích rằng chatbots có thể khiến một số cá nhân tin rằng họ đã phát hiện ra một khám phá cách mạng. Những suy nghĩ như vậy có thể trở nên nguy hiểm vì chúng ngăn cản cá nhân nhận được sự giúp đỡ thực sự.

Østergaard nói rằng các chuyên gia về sức khỏe tâm thần nên hiểu cách những công cụ AI hoạt động, để họ có thể hỗ trợ bệnh nhân tốt hơn. Mặc dù AI có thể giúp giáo dục mọi người về sức khỏe tâm thần, nó cũng có thể vô tình làm tồi tệ hơn đối với những người đã dễ bị ảo tưởng.

Bài viết mới nhất

Bài viết mới nhất

Để lại bình luận

Hủy